インテル、オープンソースのNPU高速化ライブラリを公開。最新ノートPC上で軽量LLMが動作

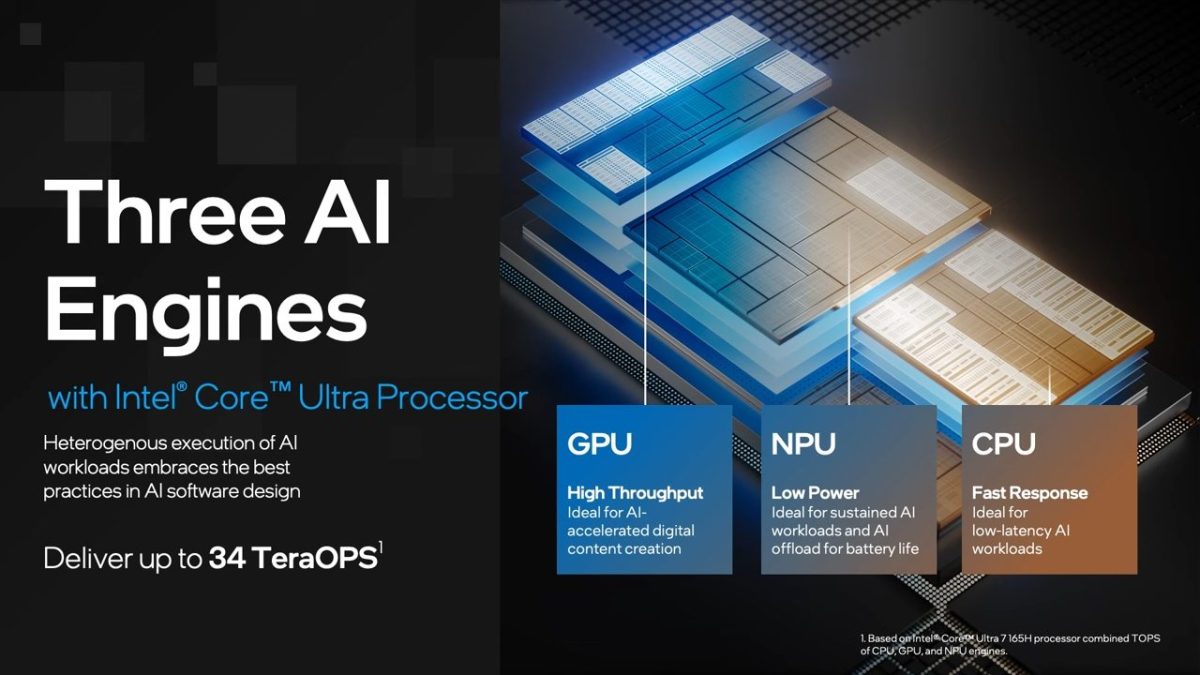

インテルはついに、オープンソースのNPU(Neural Processing Unit)アクセラレーション・ライブラリを公開した。これにより、開発者らはアプリを同社のAIエンジンに最適化でき、ローカルPC上でLLM(大規模言語モデル)を動かしやすくなった。 この一報は、インテルの技術エバンジェリスト(自社製品の特徴などを分かりやすく説明し、普及させる役職)、トニー・モンコルスマイ氏がXで述べたことだ。これにより、MSI Prestige 16 AI Evo(インテルCore Ultraプロセッサー搭載ノートPC)上で、TinyLlamaとGemma-2b-itといった軽量LLMが動かせたと付け